| Start | Web als Korpus |

| Korpustypen | Annotation |

Erstellung von Korpora

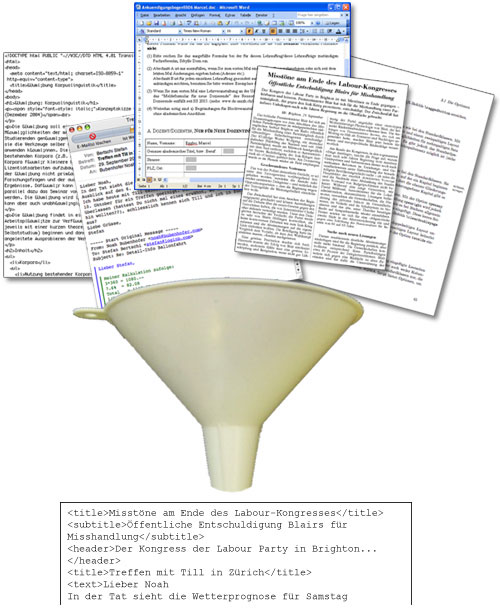

Für ein Korpus müssen die Texte in einem einheitlichen Format vorliegen. Zunächst stellt sich also das Problem, Texte, die idealerweise bereits elektronisch vorliegen, aber völlig unterschiedliche Formate aufweisen, zu vereinheitlichen. Die Dokumentstruktur beispielsweise (Titel, Fettdruck, Abstracts etc.) ist je nach Textart unterschiedlich. Texte können mit Metadaten ergänzt sein, z.B. Angaben zur AutorIn, Datumsangaben, Seitenumbrüche etc., die ggf. extrahiert oder speziell markiert werden müssen.

Diese Aufbereitung der Rohdaten muss immer wieder neu angepasst werden und geschieht meistens halbautomatisch.

Normalerweise werden neuere Korpora in XML (eXtensible Markup Language) codiert. Dieses Format ist einfach zu lesen, absolut kompatibel mit allen Betriebssystemen und Programmen und es gibt eine Reihe von Werkzeugen zur Verarbeitung von XML, die frei erhältlich sind.

Tokenisierung

Liegen die Texte in einem einheitlichen Format vor, müssen sie segmentiert werden. D.h., sie werden in kleinere Einheiten zerlegt: In Sätze und schliesslich in Token (auch: "laufende Wörter").|

«Bei einem so geringen Unterschied bei den Mandaten im Parlament kann die eine Seite der anderen Seite keine Ultimaten stellen oder irgend etwas diktieren», verkündete Schröder.

|

Betrachten wir uns obigen Satz als Ausschnitt aus einem Zeitungsartikel. Die einzelnen Token müssen nun erkannt werden. Üblicherweise wird das Token definiert als die kleinste Einheit, die durch Leerzeichen oder Interpunktion begrenzt wird. Aus dem obigen Beispielssatz ergibt sich nach der Tokenisierung folgende Liste:

|

«

Bei einem so geringen Unterschied bei den Mandaten im |

Parlament

kann die eine Seite der anderen Seite keine Ultimaten |

stellen

oder irgend etwas diktieren » , verkündete Schröder . |

Problematisch sind Ausdrücke wie z.B. Telefonnummern (044) 634 25 18 oder Zahlen wie 2'300'765 , die durch das obige Verfahren in einzelne Token getrennt wurden, aber anschliessend wieder zu einzelnen Token zusammengeführt werden müssen.

Satzgrenzenerkennung

Nach der Tokenisierung erfolgt normalerweise eine weitere Zusammenfassung von Token zu ganzen Sätzen. Dabei ist vor allem schwierig, Punkte in ihrer Bedeutung zu disambiguieren, also zu entscheiden, ob es sich um eine Satzgrenze oder um einen Punkt mit anderer Bedeutung ("Der 3. Okt. ist ein Montag.") handelt.|

Wie funktioniert Satzgrenzen-Disambiguierung?

|

Mehrere Verfahren werden angewendet, um zu entscheiden, ob es sich bei dem Satzzeichen um eine Satzgrenze handelt, oder nicht:

|

Vgl. Carstensen (2001, 371f.)

| Korpustypen | Annotation |

| Start | Web als Korpus |

Das Copyright dieses Kurses liegt bei Noah Bubenhofer. Bei Zitaten oder Verweisen darauf, freut der Autor sich über

eine Mitteilung.

Ebenso bei Fehlern und anderen Hinweisen!

Diese elektronische Ressource soll wie folgt zitiert werden: Bubenhofer, Noah (2006-2025): Einführung in die Korpuslinguistik: Praktische Grundlagen und Werkzeuge. Elektronische Ressource: http://www.bubenhofer.com/korpuslinguistik/.

Diese elektronische Ressource soll wie folgt zitiert werden: Bubenhofer, Noah (2006-2025): Einführung in die Korpuslinguistik: Praktische Grundlagen und Werkzeuge. Elektronische Ressource: http://www.bubenhofer.com/korpuslinguistik/.